Секреты быстрой индексации в яндекс и google

Содержание:

- Индексация сайта

- Как проверить индексацию

- Индексация страницы

- На домен наложен бан

- Как ускорить процесс индексации сайта в поисковых системах

- Индексация сайта в поисковых системах: как ускорить процесс

- Способы быстрой индексации сайта

- Как правильно работать с сервисами, чтобы индексация сайта в поисковых системах проходила быстро

- Индексация страниц сайта в Яндекс Вебмастер

- Пошаговая инструкция по настройке индексации

- Проверка индексации сайта: как ее выполнить

Индексация сайта

Индексация сайта — это процесс сканирования Вашего сайта поисковыми роботами и внесения всей полученной информации (текстов, ссылок, изображений и так далее) в базу поисковой системы. Соответственно, для того, чтобы Ваш сайт появился в результатах выдачи поисковой системы, он должен быть проиндексирован и добавлен в базу. Эта база и называется “индекс”. До тех пор, пока роботы поисковой системы не проиндексируют Ваш сайт, его в поисковой выдаче не будет, а это, в свою очередь, означает, что пользователи не смогут найти Ваш сайт.

Поисковая система осуществляет индексирование сайта с помощью поисковых роботов. Поисковые роботы — программы автоматизированного получения данных, бороздящие сеть в поисках информации и ссылок на информацию. Поисковый робот обращается по протоколу HTTP к серверам, на которых хранятся страницы сайта, и получает в ответ тело страниц. Робот подчиняется указаниям, прописанным в файле robots.txt , который лежит в корневой папке сервера. В robots.txt указывается, какие страницы запрещены к индексации роботом.

После обработки документа модулями робота, документ анализируется html-парсером, который оставляет только самое нужное и весомое для поиска: текст, оформление, ссылки и адреса. Все это при поиске будет влиять на ранжирование странички.

После обработки парсером происходит индексирование документа. При этом используются алгоритмы морфологического анализа. В конце концов, документ инвертируется и добавляется к основному индексу. Управление роботом поисковой системы ограничено и заключается, в основном, в установлении запретом на индексацию некоторых страниц сайта. На само расписание робота, на частоту его посещения можно лишь оказывать косвенное влияние.

Поисковый робот посещает страницу сайта исходя из того, как часто изменяется содержание этой страницы. На часто обновляемые страницы робот может ходить каждый день и даже чаще. Например, если это страница новостного сайта. Когда же страница изменяется нечасто, то робот посещает ее один-два раза в неделю. Те страницы, содержимое которых не меняется, все равно посещаются роботом, однако очень редко, не более трех раз в месяц.

При этом за один заход робот запрашивает не более 20-30 страничек с сайта. Это связано с тем, что роботы стараются не загружать сервер своими запросами. На сайт с большим количеством страниц робот ходит часто и каждый раз берет только небольшую «порцию» страниц.

Робот – это один из основных элементов любой поисковой системы. Он выполняет очень важные функции, связанные с индексацией сайтов Интернета. Из информации, добытой роботом, формируется индексная база поисковой системы, которая непосредственным образом влияет на качество поиска.

Аудитор индексирует страницы вашего сайта аналогично поисковым роботам вплоть до HTML кода, используя те же критерии ранжирования сайтов, что и поисковые системы. Переходя по доступным ссылкам на страницах сайта, аудитор сканирует страницы, собирая содержимое с учетом морфологии. Далее информация попадает в базу данных. Следующий этап- это анализ информации, после которого система выдает подробный отчет по каждой страницы вашего сайта с рекомендациями по устранению ошибок.

Как проверить индексацию

Проверка индексации – тоже очень важный момент. Нужно удостовериться, что все страницы были восприняты как надо.

Если вы добавили сайт через инструменты для вебмастеров, то статус индексации можно узнать прямо там – в соответствующем разделе. В нем будет дана подробная информация о том, когда робот посещал страницу последний раз, какой статус он ей присвоил и т. д.

Также вы можете проверить статус при помощи строки поиска. Для необходимо воспользоваться специальными операторами. Их можно найти в документации для Яндекса и Гугла.

Если вам нужна массовая проверка, то вы можете воспользоваться специальными сервисами:

- Raskruty,

- SEOGadget.

Индексация страницы

Когда Яндекс и Гугл уже познакомились с сайтом и «приняли» его в свою поисковую базу, боты будут возвращаться на ресурс, чтобы сканировать новые, добавляющиеся материалы. Чем чаще и регулярнее будет обновляться контент, тем более пристально будут следить за этим пауки.

Когда ресурс хорошо проиндексировался, выводить в поиск отдельные, новые страницы уже гораздо проще. Но тем не менее далеко не всегда анализ происходит равномерно и с одинаковой скоростью для всех, одновременно обновленных html-документов. Всегда выигрывают наиболее посещаемые и раскрученные категории ресурса.

На домен наложен бан

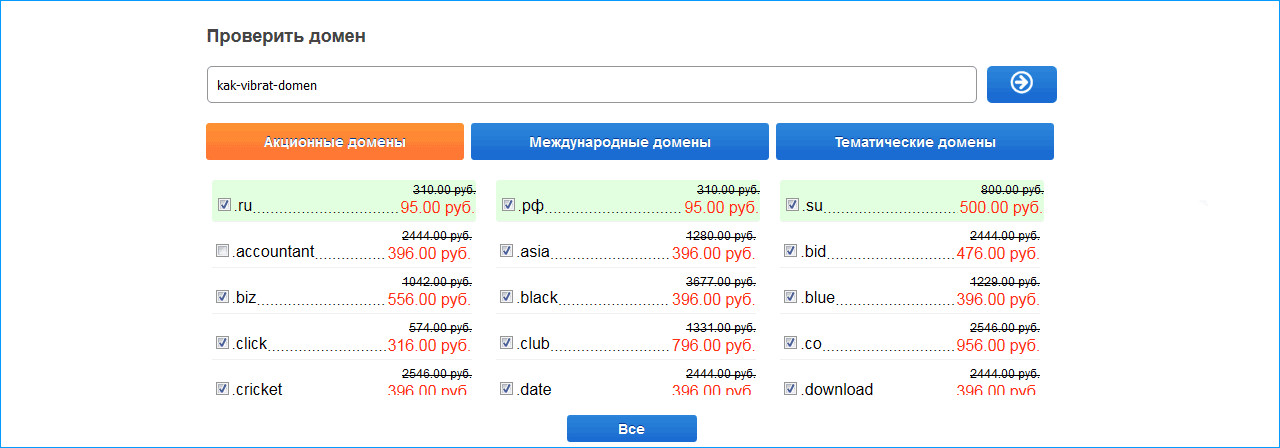

Почему сайт не в индексе, если с технической стороны у него все в порядке? Возможно, дело в домене. Перед покупкой нужно обязательно проверять его историю. В противном случае вы рискуете нарваться на домен с плохой репутацией, забаненный в поисковых системах по причине злоупотребления «черными» методами продвижения или из-за других нарушений.

Узнать историю домена можно с помощью бесплатного сервиса whois.domaintools.com. С помощью него можно увидеть, сколько раз менялись владельцы домена, сколько имеется сайтов на том же IP, к которому прикреплен домен.

Не забывайте также об архиве интернета. Здесь можно ввести URL и посмотреть, как выглядел сайт несколько лет назад. Например, это главная страница Яндекса 10 марта 2012 года:

Что делать, если сайт вылетел из индекса по причине бана? Можно связаться с техподдержкой поисковой системы через инструменты вебмастера. Возможно, с домена снимут бан, если увидят, что на нем больше не происходит ничего противоправного.

Как ускорить процесс индексации сайта в поисковых системах

Многие веб-мастера задумываются о том, как ускорить индексацию. Для начала следует понять, что такое сроки индексации. Это время между посещениями сайта поисковым роботом. И время это может варьироваться от нескольких минут (на крупных информационных порталах) до нескольких недель или даже месяцев (на забытых и заброшенных маленьких или новых сайтах).

Нередки случаи кражи контента. Кто-то может просто скопировать вашу статью и разместить у себя на сайте. Если поисковик проиндексирует эту статью раньше чем это произойдет на вашем сайте, то автором поисковики будут считать именно этот сайт, а не ваш. И хотя сегодня появились некоторые инструменты позволяющие указать авторство контента, скорость индексации страниц сайта не теряет своей актуальности.

Поэтому ниже дадим советы насчет того, как всего этого можно избежать и ускорить индексацию своего ресурса.

1. Использовать функцию «Add URL» (Добавить URL) — это так называемые аддурилки, представляющие собой формы в которые можно ввести и добавить адрес любой страницы сайта. Страница в этом случае будет добавлена в очередь на индексацию.

Она есть во многих крупных поисковиках. Чтобы вам не пришлось искать все адреса форм для добавления страниц сайта мы их собрали в отдельной статье: «Как правильно зарегистрировать сайт в поисковых системах». Данный метод нельзя назвать 100-процентной защитой от плагиата, но это хороший способ сообщить поисковику о новых страницах.

2. Зарегистрировать сайт в «Инструментах для веб-мастера» от Google и сервисе Яндекс.Вебмастер. Там можно посмотреть, сколько страниц сайта уже проиндексировалось, а сколько не проиндексировалось. Можно добавить страницы в очередь на индексацию и сделать много чего еще, при помощи доступных там инструментов.

3. Сделать карту сайта в двух форматах – HTML и XML. Первая нужна для размещения на сайте и для удобства навигации. Вторая карта нужна для поисковых систем. В ней содержатся текстовые ссылки на все страницы вашего сайта. Следовательно, при индексации робот не упустит ни одну из них. Карту сайта можно сделать при помощи плагинов для CMS или при помощи многочисленных онлайн-сервисов.

В качестве отличных решений для ее создания можно привести следующие:

- Для CMS Joomla компонент Xmap;

- Для WordPress плагин Google XML Sitemaps;

- Для CMS Drupal модуль SitemapXML;

- Универсальным инструментом для создания карты сайта может послужить сервис www.mysitemapgenerator.com.

5. Выполняйте кросспостинг в различные блог платформы. Можете создать себе блоги на таких сервисах как: Li.ru, Livejournal.com, wordpress.ru, blogspot.com и публиковать там краткие анонсы ваших статей со ссылками на их полные версии на вашем сайте.

6. Сделать RSS ленту сайта и зарегистрировать ее в различных RSS каталогах. Найти их адреса вы можете в статье: «RSS каталоги для добавления RSS ленты вашего сайта».

7. Частота обновлений сайта. Чем чаще на вашем сайте будут появляться новые материалы, тем чаще поисковые роботы будут его посещать. Для нового сайта это лучше всего делать каждый день, ну в крайнем случае через день.

8. Выполняйте грамотно внутреннюю перелинковку. На сайте должна быть грамотная система внутренних ссылок, которая будет связывать все страницы друг с другом. Поисковому роботу в этом случае будет проще переходить с одной страницы на другую. Подробнее о перелинковке: Внутренняя перелинковка — ее разновидности, способы и полезные рекомендации.

9. Размещайте на своем сайте лишь уникальный контент. Это универсальное правило, позволяющее улучшить не только процесс индексации. Чем уникальнее будет материал, тем лучше поисковики будут относиться к вашему сайту. Тем чаще поисковые роботы будут заходить к вам в гости.

Данных методов по ускорению индексации будет вполне достаточно для молодого или среднего по возрасту сайта. Они не будут занимать у вас много времени и имеют хороший эффект.

Индексация сайта в поисковых системах: как ускорить процесс

Индексация сайта в поисковых системах может проводиться и быстрее. Но только в том случае, если соблюдать все предусмотренные требования. Главное из них – как именно вы решили добавить проект в поисковую систему: оптимальный вариант подразумевает использование панели инструментов вебмастеров. После чего там будут появляться рекомендации – следует обязательно читать их и выполнять. Таким образом, скорость индексации страниц существенно вырастет.

1. Качественный контент

Уделите особое внимание качеству материалов, которые вы готовите для своего сайта. Чем более интересными, полезными для читателей они будут, тем более высока вероятность быстрой индексации – на нее будет уходить всего лишь несколько часов, а не суток

2. Скорость загрузки

Необходимо оптимизировать сайт и материалы так, чтобы скорость загрузки страниц была максимально быстрой. Для этого необходимо уменьшить вес картинок, проработать HTML, CSS, JS. Также на скорость загрузки страницы оказывает непосредственное воздействие хостинг

Уделите повышенное внимание его подбору – чем он качественнее, тем лучше работает сайт в целом

3. Структура сайта

Также нужно проработать структуру сайта, дабы она была правильной, понятной для пользователей, удобной и простой для навигации по страницам проекта.

4. Перелинковка

Необходимо обязательно делать внутреннюю перелинковку. Это необходимо по одной простой причине – когда робот индексирует страницу, он также обязательно прорабатывает «документы», на которые стоят ссылки.

5. Файл robots.txt

Этот файл являет собой своеобразную инструкцию для поисковых роботов. В ней нужно прописать, какие страницы не нужно анализировать и добавлять в поисковую выдачу. Так вы избавите её от всяких ненужных разделов. Это полезно для проекта в целом. Ведь «машины» будут чаще приходить на проект, если увидят, что на нем нет «мусорных» для пользователей разделов.

6. XML-карта сайта

Необходимо обязательно создать ее и добавить в панели для вебмастеров. Посредством такой карты роботы лучше ориентируются в представленных на ресурсе материалах. Что способствует более оперативной индексации.

8. Проверка на ошибки

Также следует постоянно проводить проверку сайта на ошибки. Если они имеются, обязательно устранять их. Самые критические, опасные отображаются в консоли вебмастеров. Кроме того, имеются особые валидаторы, которые помогают выявить недочеты в коде сайта.

Способы быстрой индексации сайта

Если добавить ваш новый веб-ресурс в поисковые системы, которые вы знаете, индексация сайта произойдет гораздо быстрей. Добавить в Yandex — https://webmaster.yandex.ru/addurl.xml, в Google — https://www.google.ru/intl/ru/addurl.html.

Нужно создать карту сайта. Зарегистрироваться в сервисах webmaster.yandex.ru и www.google.com/webmasters. Указать там ваш файл sitemap.xml.

Для ускорения индексации сайта вам поможет регистрация в социальных закладках и сетях (bobrdobr.ru, memori.ru, twitter.com, vkontakte.ru и др.). Там можно добавлять разные страницы вашего сайта.

Заведите свои блоги на my.ya.ru, blogspot.com, blogs.mail.ru, livejournal.com и др. Добавьте в них записи со ссылками на страницы вашего сайта. По мере возникновения новых страниц на сайте, для их быстрой индексации поисковиками, добавляйте ссылки в ваших блогах на эти страницы.

Стоит зарегистрироваться в нескольких популярных каталогах и рейтингах. К примеру, регистрация на LiveInternet и Рамблер ТОП100 способна ускорить индексацию сайта из-за того, что роботы довольно часто заглядывают в ТОПы.

Поисковые боты очень любят посещать популярные блоги с их комментариями. При этом роботы тщательно отслеживают все ссылки в блогах. Попробуйте посещать такие блоги и оставлять там ненавязчивые комментарии со ссылками. Старайтесь соблюдать правила блога и ссылки вставлять в специально отведенные для этого места во избежание удаления вашего комментария как спама.

Еще один похожий совет для ускорения индексации сайта — это комментарии на форумах с большой посещаемостью. Как раз на форумах, кстати, абсолютно не запрещено вставлять ссылки, если они имеют отношение к вашему ресурсу. Форумы посещаются ботами не хуже чем блоги.

Довольно трудоемкими, но популярными считаются способы быстрой индексации веб-ресурсов при помощи размещения на сторонних ресурсах большого количества статей со ссылками на ваш сайт. Трудоемкость заключается в написании огромного количества статей с интересным и актуальным содержанием. Эти статьи выполняют функцию, подобную каталогу ссылок.

Необходимо построить четкую и грамотную структуру сайта. Ее построение должно быть легким и удобным для работы поисковых роботов со страницами сайта. Достичь этого вовсе не трудно. Принцип заключается в том, чтобы ссылки на всех страницах сайта направляли посетителя с одной страницы на другую.

Если ваш проект содержит огромное количество страниц, то для быстрой индексации сайта следует обратить внимание на следующий метод. Робот поисковика считывает и анализирует информацию, постепенно передвигаясь по страницам сайта

При довольно значительном количестве страниц он может просто не добраться до части последних страниц, которые значительно удалены от главной. При этом индексация сайта в поисковых системах ухудшается.

Идеальной в таком случае является древообразная четкая структура карты вашего сайта, в которой каждому ответвлению будет соответствовать некоторый подраздел с меньшим количеством страниц. Каждая страница сайта, желательно, должна быть в удалении не более трех кликов от главной.

В случае, если отдельные страницы сайта поисковые роботы не проиндексировали, следует ссылки на эти страницы разбросать по сторонним ресурсам. При индексации сайтов с вашими ссылками робот обязательно посетит и ваши страницы.

Чтобы индексация сайта происходила быстрей, необходимо обеспечить более частое посещение роботами его страниц. Для достижения этого вам придется довольно часто обновлять страницы сайта и пополнять новой информацией

И самое важное при этом наполнять сайт статьями и текстами со стопроцентной уникальностью

Как правильно работать с сервисами, чтобы индексация сайта в поисковых системах проходила быстро

Основными поисковыми системами, используемыми в нашей части планеты, являются Google и Yandex. Именно через них люди ищут необходимую информацию, статьи, сайты. Поэтому и оптимизировать ресурсы нужно под требования данных поисковых сервисов.

Как сообщить поисковым роботам о новом сайте

Когда запускается новый сайт, логично, что поисковые системы и роботы о нем ничего не знают. Поэтому, дабы ваш проект был включен в выдачу, необходимо передать сервисам эту информацию. Сделать «передачу» можно двумя способами.

1. Поместить ссылки на сайт на других ресурсах

Наличие таких ссылок как будто дает команду поисковым роботам: «Внимание! Смотрите! Появился новый полезный и интересный для людей проект». Они переходят по ссылкам и индексируют страницы ресурса, анализируют их и собирают нужную для ранжирования информацию

2. Использовать профильные инструменты

Чтобы проводилась индексация сайта в поисковых системах, также можно использовать специализированные сервисы для вебмастеров, имеющиеся в поисковых системах. Они также позволяют получать важную информацию о вашем сайте:

- статистику посещений;

- количество посетителей;

- число показов;

- число кликов;

- удаленные страницы;

- добавленные страницы;

- и многое другое.

Анализ этой информации позволяет вносить изменения в сайт, делать его более полезным, ценным, проводить внутреннюю и внешнюю оптимизацию.

Добавив свой проект в указанные сервисы, вы также даете команду поисковым роботам провести индексацию страниц. Если на страницах сайта нет команды, способной закрыть сайт от индексации (такие запреты обычно прописываются в файле Robots.txt или через специальные мета-теги), роботы просканируют проект, соберут информацию и добавят его в поисковую базу для последующей выдачи.

Не стоит думать, что добавление сайта в поисковую базу – это обязательный доступ к статьям по тем или иным поисковым запросам. Для этого – чтобы статью можно было найти посредством «ключей» — необходимо определенное время. Иногда – даже слишком продолжительное. Все зависит от нескольких факторов. Однако рано или поздно поисковые роботы таки проведут оценку содержимого сайта и добавят его страницы в выдачу.

Если вас интересуют конкретные сроки, то после отправки сообщения о странице, сайте и до появления в выдаче нужно от 7 до 15 дней.

Дополнительный инструмент для добавления сайта в базу поисковых систем

Кроме двух методов, представленных выше, есть еще один способ, как добавить сайт в базу поисковых систем. Хотя его эффективность чуть ниже. Суть его заключается в введение в поисковую строку специальной команды:

- для Google — Site: Название + project.com;

- для Яндекс — Host: Название + project.com, где project.com – домен вашего проекта.

Индексация страниц сайта в Яндекс Вебмастер

Статистика обхода в Яндекс Вебмастер

Для начала зайдем в пункт «Статистика обхода». Раздел позволяет узнать, какие страницы вашего сайта обходит робот. Вы можете выявить адреса, которые робот не смог загрузить из-за недоступности сервера, на котором находится сайт, или из-за ошибок в содержимом самих страниц.

Раздел содержит информацию о страницах:

- новые – страницы, которые недавно появились на сайте либо робот их только что обошел;

- изменившиеся – страницы, который поисковик Яндекса раньше видел, но они изменились;

- история обхода – количество страниц, которые обошел Яндекс с учетом кода ответа сервера (200, 301, 404 и прочие).

На графике отражены новые (зеленый цвет) и изменившиеся (синий цвет) страницы.

А это график истории обхода.

В этом пункте отображены страницы, которые Яндекс нашел.

N/a – URL не известен роботу, т.е. робот её раньше не встречал.

Какие выводы из скрина можно сделать:

- Яндекс не нашел адрес /xenforo/xenforostyles/, что, собственно, логично, т.к. этой страницы больше нет.

- Яндекс нашел адрес /bystrye-ssylki-v-yandex-webmaster/, что тоже вполне логично, т.к. страница новая.

Итак, в моем случае в Яндекс Вебмастере отражено то, что я и ожидал увидеть: что не надо – Яндекс удалил, а что надо – Яндекс добавил. Значит с обходом все у меня хорошо, блокировок никаких нет.

Страницы в поиске

Поисковая выдача постоянно меняется – добавляются новые сайты, удаляются старые, корректируются места в выдаче и так далее.

Информацию в разделе «Страницы в поиске» вы можете использовать:

- для отслеживания изменений количества страниц в Яндексе;

- для слежения за добавленными и исключенными страницами;

- для выяснения причин исключения сайта из поисковой выдачи;

- для получения информации о дате посещения сайта поисковиком;

- для получения информации об изменении поисковой выдачи.

Чтобы проверить индексацию страниц и нужен этот раздел. Здесь Яндекс Вебмастер показывает страницы, добавленные в поисковую выдачу. Если все ваши страницы добавлены в раздел (новый добавятся в течение недели), то значит со страницами все в порядке.

Пошаговая инструкция по настройке индексации

Перед тем, как отправить сайт на индексацию поисковыми системами, необходимо произвести предварительную подготовку. Связано это с несколькими моментами:

- Грамотная предварительная работа исключит индексацию роботом поисковой системы лишней или не до конца оформленной и прописанной информации.

- При обнаружении роботом недочетов — непрописанных мета-данных, грамматических ошибок, незакрытых неинформативных ссылок — поисковая система ответит владельцу сайта низким рейтингом, некорректной подачей материала в выдаче и т.п.

- Пока производится подготовительная к демонстрации «поисковикам» работа, необходимо скрыть информацию от роботов и индексации соответствующей записью в файле robots.txt.

Правильная подготовка к индексации будет включать в себя:

1.Разработку мета-тегов, description и title страниц:

- Title должен содержать не более 60 знаков. Это основной заголовок страницы и самый важный из тегов.

- Description состоит из читабельных фраз, позиционирующих данную страницу, то есть необходимо прописать основные тезисы, о чем именно пойдет речь в данном материале.

- Тег keywords предполагает прописывание всех возможных слов по данному вопросу. В последнее время ценность этого тега уменьшилась в глазах поисковых систем, поисковых подсказок.

- Мета-тег revisit (или revisit-after) будет говорить о том сроке, когда планируются обновления сайта, это своего рода просьба-рекомендация оптимизатора для робота, указывающая оптимальный промежуток времени до следующей проверки ресурса.

2. Сокрытие внутренних и неинформативных разделов сайта. Производится эта робота также в файле robots.txt. «Поисковик» считает такого рода информацию «сорной», а потому это будет минусом в процессе проверки ресурса.

3. Необходимо также скрыть и ссылки на разделы служебного характера, которые расположены в содержимом сайта. Для этого используются команды noindex (для Яндекса) и nofollow (для всех «поисковиков»).

4. Незакрытые внешние ссылки на другие сайты могут привести к снижению веса сайта. Поэтому их тоже необходимо скрывать от роботов.

5. К выделению ключевых слов и основных моментов жирным необходимо относиться аккуратно, поскольку поисковая система расценивает эти слова как самые важные, что не всегда является так фактически.

6. Все имеющиеся изображения необходимо подписать тегом alt.

7. Необходимо проверить тексты на количество ключевых слов и оборотов в тексте, чтобы робот не проигнорировал информацию в связи с высоким показателем тошноты текста.

8. Обязательным пунктом перед подачей заявки в поисковые системы на индексацию ресурса является проверка орфографии, ошибок грамматического и стилистического характера. При наличии таковых в дескрипшн система выдаст информацию именно в таком виде, что может отсеять большой процент желающих посетить сайт еще на этапе выдачи по запросу.

Для того, чтобы ресурс вышел в числе других в выдаче по поисковому запросу пользователя, необходимо настроить индексацию в основных используемых поисковых системах:

2. Яндекс.Вебмастер:

Помимо индексации в основных системах, не стоит забывать и о чуть менее известных «поисковиках»:

- Рамблер ориентируется на индексацию ресурса в Яндексе, поэтому для добавления в его базу индекса достаточно пройти индексацию в основной поисковой системе.

- Индексацию в Mail.ru производят здесь: http://go.mail.ru/addurl

- Трафик русской поисковой системы Nigma.ru составляет около 3000000 в сутки. Подать заявку на индексацию в этой системе можно здесь: http://www.nigma.ru/index_menu.php?menu_element=add_site.

Проверка индексации сайта: как ее выполнить

Теперь про еще один важный момент. Обязательно нужно проверять, как проводится индексация ресурса. Необходимо убедиться, что все страницы проекта восприняты роботами правильно, адекватно.

Как выполняется проверка индексации сайта? Все зависит от того, как именно вы его добавляли. Например, если через «официальные» инструменты в панели вебмастеров поисковых сервисов – все просто. Статус представлен в отдельном разделе. Там указывается вся нужная и актуальная информация:

- какой статус страницы;

- когда ее роботы посещали последний раз;

- и многое другое.

Еще один метод – использовать поисковую строку. Суть – в том, дабы использовать специальных операторов, информация о которых представлена в официальной документации для поисковых систем.

Также можно использовать отдельные сервисы, разработанные для этих целей. Ими нужно пользоваться в случаях, если необходима полномасштабная проверка множества страниц. Такие сервисы существенно упрощают жизнь вебмастерам и SEO-оптимизаторам. Среди них можно выделить два:

- Raskruty;

- SEOGadget.

Они простые для понимания. Есть инструкции по работе с ними. Поэтому отдельно расписывать их не буду.